Cuando escribes cualquier palabra en el buscador de Google, y aunque no siempre dé en el clavo a la primera, hay detrás todo un conjunto de herramientas y procesos destinados a encontrar la información que pides. Empiezan mucho antes y acaban cuando los enlaces se muestran en tu pantalla.

Una parte importante de este ‘software’ es Googlebot, un sistema de ‘arañas’ informáticas que rastrea la web continuamente en busca de nuevas páginas que añadir a la biblioteca de la que luego extrae las que mejor coinciden con tu solicitud. Su trabajo es meter las novedades en el índice de búsqueda, actualiza los cambios y elimina los enlaces obsoletos.

Para cumplir con su labor, las ‘arañas’ de Google acceden al contenido de un sitio web y lo analizan en cuestión de segundos. En principio, no habría nada de qué sospechar, pero ¿qué pasa si en vez de ser el robot rastreador del gigante tecnológico se tratara de un imitador?

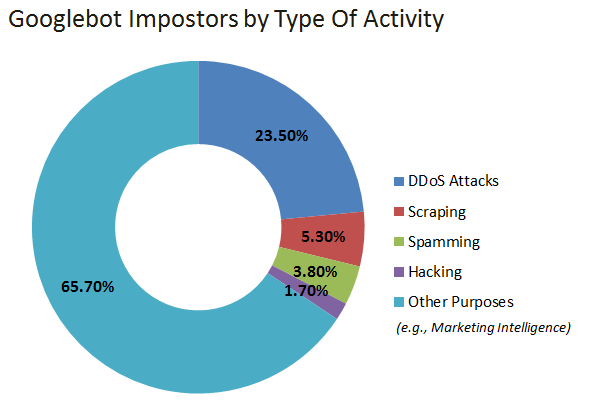

Según un estudio, más de 50 millones de falsos ‘bots’ visitan 10.000 sitios web cada mes. El trabajo también revela que el 4% de todos los rastreadores que acceden a una página no son lo que dicen sus credenciales.

Además, de todos los impostores, el 23,5% son utilizados por los hackers para perpetrar lo que en seguridad informática se denominan ataques de denegación de servicio (DDoS, por sus siglas en inglés). Gracias a ellos, los falsos robots acceden al servidor donde se guardan los archivos de una web por la misma puerta que sus versiones legítimas.

Como todo lo que circula a través de Internet, los rastreadores (ya sean buenos o malos) entran en estos ‘equipos almacén’ a través de una conexión con un ancho de banda determinado.

La diferencia está en que las arañas de Google llegan a las carpetas y documentos con cuidado de no colapsar el servicio, mientras que los ‘bots’ responsables de los DDoS hacen precisamente lo contrario: envían gran cantidad de información concentrada en un corto lapso de tiempo para utilizar toda la capacidad de transmisión de datos del servidor y echarlo abajo.

Los resultados del trabajo de investigación son solo una prueba fehaciente de que este tipo de ataques se está convirtiendo en algo muy común en la red. Una de las razones es que resulta imposible desaparecer del mapa de los rastreadores de Google si el creador de una página quiere tener algún impacto en Internet. Cuando las arañas no acceden a su contenido, la web dejará de formar parte del índice del buscador (y, ya se sabe, si no sales en Google, no existes).

Si, aún con estas, un ‘webmaster’ prefiere escapar de cualquier tipo de intrusión, puede utilizar el documento robots.txt. Guardando este archivo en el directorio principal de su ‘site’ bloquea la entrada a los lacayos del gigante tecnológico. Claro que, como decíamos, también pierde visibilidad en la red.

Otro punto a su favor es que cada vez hay más herramientas de seguridad para identificar a los ‘googlebots’ mediante una verificación cruzada de la dirección IP – el conjunto de números que constituyen algo así como el DNI de un ordenador – de la que procede el ‘software’ intruso. De esta forma, puede saberse si procede de Google o el emisor del ataque es un operador desconocido.